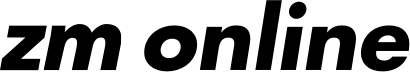

Pflegeroboter wird zum universellen Assistenten

Er bringt morgens Wasser und Frühstück ans Bett, vermittelt Gespräche mit Ärztinnen und Ärzten, ermöglicht telemedizinische Untersuchungen und hilft bei Reha-Übungen sowie beim Aufstehen. Der Assistenzroboter GARMI wird immer vielfältiger und intelligenter. Wie die Forschenden aus dem Munich Institute of Robotics and Machine Intelligence (MIRMI) der TUM auf der Robotikmesse ICRA 2024 in Yokohama in Japan zeigen, versteht der Roboter nicht nur diverse Kommandos per ChatGPT, sondern setzt so unterschiedliche Aufgaben und Fertigkeiten wie das Greifen von Gegenständen, sicheres Manövrieren und die Kommunikation mit Patientinnen und Patienten autonom um. Zudem vermittelt er Live-Gespräche mit Ärztinnen und Ärzten, die telemedizinische Untersuchungen vornehmen, heißt es in einer Mitteilung. „GARMI ist nun in der Lage, diverse Einzelfähigkeiten, die wir ihm in den letzten Jahren beigebracht haben, sicher und auf Zuruf über ChatGPT auszuführen“, erläutert der Leiter des Geriatronik-Projekts Dr.-Ing. Abdeldjallil Naceri.

ChatGPT übernimmt die Kommunikation

Dafür verbinden die Forschenden diverse technologische Innovationen miteinander. Ein digitaler Zwilling kommt zum Einsatz, um die Bewegungen des Roboters vor der realen Interaktion mit dem Menschen in einer Simulation durchzuprobieren und so Zusammenstöße zu vermeiden. Künstliche Intelligenz (KI) trägt dazu bei, dass GARMI Tassen und Gläser greifen und herüberreichen kann, ohne Flüssigkeit zu verschütten. Und ChatGPT übernimmt als Bindeglied die Kommunikation zwischen Roboter, Patientinnen und Patienten, Physiotherapeutinnen und Physiotherapeuten sowie Ärztinnen und Ärzten.

Damit GARMI ähnlich wie Menschen greifen kann, haben die Forschenden eine Kamera, einen Roboterarm mit sieben Gelenken und künstlicher Hand sowie künstliche Intelligenz zusammengebracht. Zunächst macht die Kamera ein Bild von dem Objekt, das GARMI greifen soll und identifiziert es über den Einsatz von neuronalen Netzen als Tasse, Flasche oder Ball. Da die Kamera nur von einer Seite das Objekt sieht, ergänzt das System nicht-sichtbare Bereiche etwa einer Tasse, indem es das Gesehene mit anderen Bildern vergleicht und rekonstruiert das vollständige 3-D-Objekt. Die Wahrscheinlichkeiten, mit denen das Objekt so dargestellt wird, wie es in Wirklichkeit aussieht, stellen die Forschenden in einer farblich abgestuften Grafik dar, einer „Heatmap“. So lässt sich die ideale Position für die Hand ermitteln, die etwa eine Tasse greifen soll. In neun von zehn Fällen ist das komplexe System nun dazu in der Lage. „Wenn es mit einer Tasse klappt, kann unser System das auf alle anderen Tassenformen übertragen“, sagt Naceri.

Kann der Roboter perspektivisch Patienten ultraschallen?

Um erforschen zu können, ob Ärztinnen und Ärzte per Teleoperation mit Patientinnen und Patienten zusammenarbeiten können, dachten sich die Forschenden einen besonderen Versuchsaufbau aus. Dafür zeichneten sie auf einem digitalen Grafik-Tablet einfache Formen. GARMI wurde ebenfalls mit einem Stift in einer Hand und mit einer Kamera in der anderen ausgestattet. Einen Raum entfernt sollte der Roboter auf eine Leinwand übertragen, was die Forschenden zuvor gezeichnet haben – also eine einfache Zeichnung in ein komplexes robotisches System projizieren. Es stellte sich heraus, dass die besten Kreise, Quadrate und Dreiecke dann entstanden, wenn GARMI die Kamera autonom einsetzte, eine Erkenntnis, die künftig in die Zusammenarbeit zwischen behandelnden Medizinerinnen und Mediziner und Patientinnen und Patienten einfließt. Denn beispielsweise bei einer Ultraschalluntersuchung geht es darum, den Ultraschallkopf möglichst präzise aufzusetzen oder bei einer Reha-Übung, Bewegungen richtig auszuführen.

In einer neuen Forschungsarbeit zeigen die Forschenden, wie Werkzeuge an einem Gegenstand vorbeimanövriert werden können. Die Herausforderung besteht darin, einerseits die Abstände im Auge zu behalten und andererseits die Beweglichkeit des Roboterarms mit allen seinen Gelenken richtig einzuschätzen. Gelingt das, kann der Roboter sogar entgegenfliegenden Bällen ausweichen.

Die Reaktionszeit beträgt eine Millisekunde

GARMI verarbeitet Informationen mit einer Taktung von einer Millisekunde. Das betrifft die Wahrnehmung, Interaktion und Navigation gleichermaßen. Die Kraftsensoren der Roboterarme registrieren geringste Berührungen und reagieren sofort. Stößt ein Mensch versehentlich gegen den Arm des Roboters, bleibt er aus Sicherheitsgründen innerhalb von einer Millisekunde stehen. Um Unfälle auszuschließen, treffen Mensch und Roboter zunächst als digitale Zwillinge in einem virtuellem Umfeld aufeinander. Das ist unerlässlich, denn der Assistenzroboter kann in der Wohnung eines Pflegeheims theoretisch bis zu 20 Stundenkilometer schnell werden. In der Computersimulation registriert er mithilfe der Safety Motion Unit über seine Sensoren, wenn ihm eine Person zu nah kommt und bewegt sich langsamer. Entfernt sich die Person, bewegt er sich wieder schneller.

Das KI-Tool ChatGPT funktioniert als Übersetzer zwischen Technik und Mensch. Es hat diverse Kommandos wie „Starte die Reha“, „Zeig mir das Wetter von morgen“ oder „Ruf den Arzt an“ gelernt, und GARMI nutzt dieses Tool, um mit Patientinnen und Patienten zu kommunizieren. „Aktuell haben die Forschenden eine Liste von 15 bis 20 Kommandos, die bestimmte Aktionen triggern. „Potenziell können wir sie beliebig erweitern“, sagt Robotik-Forscher Naceri, „das MIRMI gehört damit zu den ersten Instituten, in denen Roboter und Menschen mithilfe von ChatGPT miteinander interagieren.“

Der neue universelle GARMI wird nun in einer Musterwohnung in Garmisch-Partenkirchen aktiv. Das Hauptforschungsfeld wird die Weiterentwicklung von Händen sein, die immer feinere Aufgaben übernehmen können. Bis GARMI letztlich in Pflegeheimen zum Einsatz kommt, werden noch einige Jahre vergehen. „Es ist wie mit dem autonomen Auto“, sagt Naceri, „es sind schon große Fortschritte gemacht worden, doch fehlen noch ein paar Details, um es im Umfeld des Menschen einsetzen zu können.“