Besteht ChatGPT den Praxistest?

Bereits im Jahr 1950 entwickelte der britische Mathematiker und Kryptologe Alan Turing einen Imitationstest, mit dem man die Qualität einer Maschine mit Künstlicher Intelligenz auf einfache Weise prüfen konnte: Kann die Konversation mit einer Maschine nicht mehr von der mit einem Menschen unterschieden werden, kann von einer sehr hohen Qualität der KI ausgegangen werden [Turing, 1950]. In diesem Sinne überraschte das im November 2022 vorgestellte dialoggestützte Sprachmodell ChatGPT vielfach mit Auskünften, die nur schwer von menschlichen Antworten zu unterscheiden waren. Das traf auch für die Beantwortung medizinischer Fragestellungen zu, wie erste Analysen zeigten [Nov et al., 2023]. Schlagartig wurde deutlich, dass hier eine Technologie entsteht, die vielfältige Anwendungsbereiche auch in der Zahnmedizin erschließen könnte.

Im Folgenden sprechen die (menschlichen) Autoren dieses Artikels mit ChatGPT und kommentieren diese Konversation. Anschließend werden sie die Technologie kritisch bewerten.

ChatGPT im Interview

Was ist ChatGPT?

ChatGPT: ChatGPT ist ein künstlicher Intelligenz-basierter Chatbot, der durch maschinelles Lernen trainiert wurde, um auf natürliche Sprache zu reagieren und menschenähnliche Konversationen zu führen. ChatGPT basiert auf einem Deep-Learning-Modell namens Generative Pre-trained Transformer (GPT), das auf einer enormen Menge von Texten trainiert wurde. Durch das Training auf einer breiten Palette von Texten kann ChatGPT auf eine Vielzahl von Fragen und Anfragen antworten und menschenähnliche Antworten generieren.

ChatGPT wird in vielen verschiedenen Bereichen eingesetzt, wie zum Beispiel für den Kundensupport, für Sprachsteuerungen oder für die Erstellung von Texten. Unternehmen und Organisationen nutzen ChatGPT, um schnell und effizient auf Kundenanfragen zu reagieren oder um die Interaktion mit Benutzern zu verbessern.

Welche Prozesse können large language models (LLM) wie ChatGPT in einer Zahnarztpraxis verändern?

ChatGPT: Large language models wie ChatGPT können in einer Zahnarztpraxis eine Reihe von Prozessen verändern. Einige Beispiele sind:

1. Patientenkommunikation: ChatGPT könnte in einer Zahnarztpraxis eingesetzt werden, um Patientenfragen auf der Website oder über Chatbots zu beantworten. Durch die Verwendung von ChatGPT können Zahnärzte schnelle und präzise Antworten auf häufig gestellte Fragen wie „Wie oft sollte ich meine Zähne putzen?“ oder „Wie kann ich meine Zahnfleischentzündung behandeln?“ bereitstellen, ohne dass ein Mitarbeiter diese beantworten muss.

2. Terminvereinbarung: ChatGPT könnte auch verwendet werden, um Termine zu vereinbaren und zu bestätigen. Ein Chatbot, der mit ChatGPT betrieben wird, könnte eine Konversation mit dem Patienten führen und einen Termin entsprechend der Verfügbarkeit des Zahnarztes planen. Dies kann Zeit sparen und den Verwaltungsaufwand reduzieren.

3. Diagnose-Unterstützung: ChatGPT kann auch zur Unterstützung bei Diagnosen eingesetzt werden. Ein Zahnarzt könnte bestimmte Symptome oder Ergebnisse eines Röntgenbilds eingeben, und ChatGPT könnte mögliche Ursachen vorschlagen oder Diagnose-Optionen angeben, um die Entscheidungsfindung des Zahnarztes zu unterstützen.

4. Patientenaufklärung: ChatGPT könnte auch als eine Ressource für Patientenaufklärung dienen. Zahnärzte könnten Texte, Anleitungen und Informationen zu bestimmten Behandlungen oder Vorgehensweisen in ChatGPT einspeisen. Patienten könnten dann auf diese Ressourcen zugreifen, um ihre Fragen zu beantworten und sich auf die Behandlung vorzubereiten.

Insgesamt können large language models wie ChatGPT in einer Zahnarztpraxis dazu beitragen, den Workflow und die Effizienz zu verbessern, indem sie den Patientenservice und die Interaktion mit Patienten erleichtern. ChatGPT kann jedoch keine Diagnosen stellen oder Behandlungen durchführen und sollte nur als Unterstützung des Zahnarztes dienen.

[Anmerkung der Autoren: ChatGPT soll also unter anderem die Patientenaufklärung erleichtern. Funktioniert dies denn auch zielgruppenspezifisch? Wir haben es ausprobiert.]

Erkläre Parodontitis für ein 6-jähriges Kind.

ChatGPT: Parodontitis ist eine Krankheit, die das Zahnfleisch und die Zähne krank macht. Es ist, als ob winzige „Käfer" in deinem Mund leben, die das Zahnfleisch angreifen und die Zähne schwach machen. Wenn man die „Käfer" nicht entfernt, können sie Schaden anrichten und dazu führen, dass man Zähne verliert. Deshalb ist es wichtig, regelmäßig die Zähne zu putzen und zum Zahnarzt zu gehen, damit er dir hilft, die „Käfer" loszuwerden und deine Zähne gesund zu halten.

Erkläre Parodontitis für einen Mikrobiologen.

ChatGPT: Parodontitis ist eine bakterielle Infektion des Zahnhalteapparats, die durch bestimmte Bakterienstämme, wie zum Beispiel Porphyromonas gingivalis, Treponema denticola oder Tannerella forsythia, ausgelöst wird. Diese Bakterien bilden biofilmartige Strukturen, die sich auf der Zahnoberfläche ablagern und im Zusammenspiel mit dem Immunsystem des Wirts zu einer Entzündung des Zahnfleischs und des umgebenden Gewebes führen.

Infolge dieser Entzündung können tiefe Zahnfleischtaschen entstehen, die als ideale Brutstätte für Bakterien dienen und den weiteren Verlauf der Erkrankung negativ beeinflussen können. Die Pathogenese der Parodontitis ist äußerst komplex und involviert neben der Bakterien-Host-Interaktion auch eine Vielzahl von genetischen, immunologischen und umweltbedingten Faktoren. Die Behandlung von Parodontitis beinhaltet in der Regel eine gründliche Reinigung der betroffenen Zahnflächen sowie eine antimikrobielle Therapie und eine unterstützende Parodontitistherapie.

[Anm. der Autoren: In Aufklärungsgesprächen besteht oft das Problem, dass Patienten keinerlei Vorinformationen haben und gezielte Fragen erst nach dem eigentlichen Gespräch entstehen. Chatbots wie ChatGPT könnten eine Art Voraufklärung leisten, um Patienten mit dem Thema vertraut zu machen. Auch das haben wir an einem Beispiel ausprobiert.]

Was sind die Risiken einer Weisheitszahnentfernung im Unterkiefer?

ChatGPT: Wie bei jeder Operation gibt es auch bei der Entfernung der Weisheitszähne im Unterkiefer bestimmte Risiken. Hier sind einige der möglichen Risiken:

1. Schmerzen und Schwellungen: Schmerzen und Schwellungen im Bereich des Operationsgebiets sind nach der Entfernung der Weisheitszähne normal und können einige Tage anhalten. Schmerzmittel und kalte Kompressen können zur Linderung der Beschwerden eingesetzt werden.

2. Blutungen: Nach der Operation können Blutungen im Operationsgebiet auftreten, die normalerweise von alleine aufhören. Wenn die Blutung jedoch stark oder anhaltend ist, sollte unverzüglich ein Arzt aufgesucht werden.

3. Infektionen: Obwohl selten, können nach der Weisheitszahnentfernung Infektionen im Operationsgebiet auftreten. Symptome können Schmerzen, Schwellungen, Fieber und Schüttelfrost sein. Eine Infektion kann mit Antibiotika behandelt werden.

4. Nervenschädigung: Die Nerven im Kiefer können durch die Entfernung der Weisheitszähne beeinträchtigt werden, insbesondere im Unterkiefer, wo der Nerv, der das Gefühl in der Zunge und im Unterkiefer kontrolliert, verläuft. Eine vorübergehende oder dauerhafte Sensibilitätsveränderung kann auftreten, wenn der Nerv während der Operation geschädigt wird.

5. Kieferbruch: In seltenen Fällen kann es während der Weisheitszahnentfernung im Unterkiefer zu einem Kieferbruch kommen. Dies ist besonders bei Patienten mit schwachem Kieferknochen oder schwierigen Extraktionsbedingungen wahrscheinlicher.

6. Andere Risiken: Zu den weiteren möglichen Risiken gehören eine verzögerte Heilung, Probleme mit der Mundöffnung, Atembeschwerden und allergische Reaktionen auf Anästhesie oder Medikamente.

Es ist wichtig, dass Sie mit Ihrem Zahnarzt oder Kieferchirurgen alle Risiken und möglichen Komplikationen besprechen, bevor Sie sich für eine Weisheitszahnentfernung entscheiden.

Kritische Bewertung

In der folgenden Bewertung fokussieren wir uns auf vier Aspekte: inhaltliche Qualität, Interpretation und Verlässlichkeit, Verbreitung von Falschinformationen, Ethik.

Inhaltliche Qualität

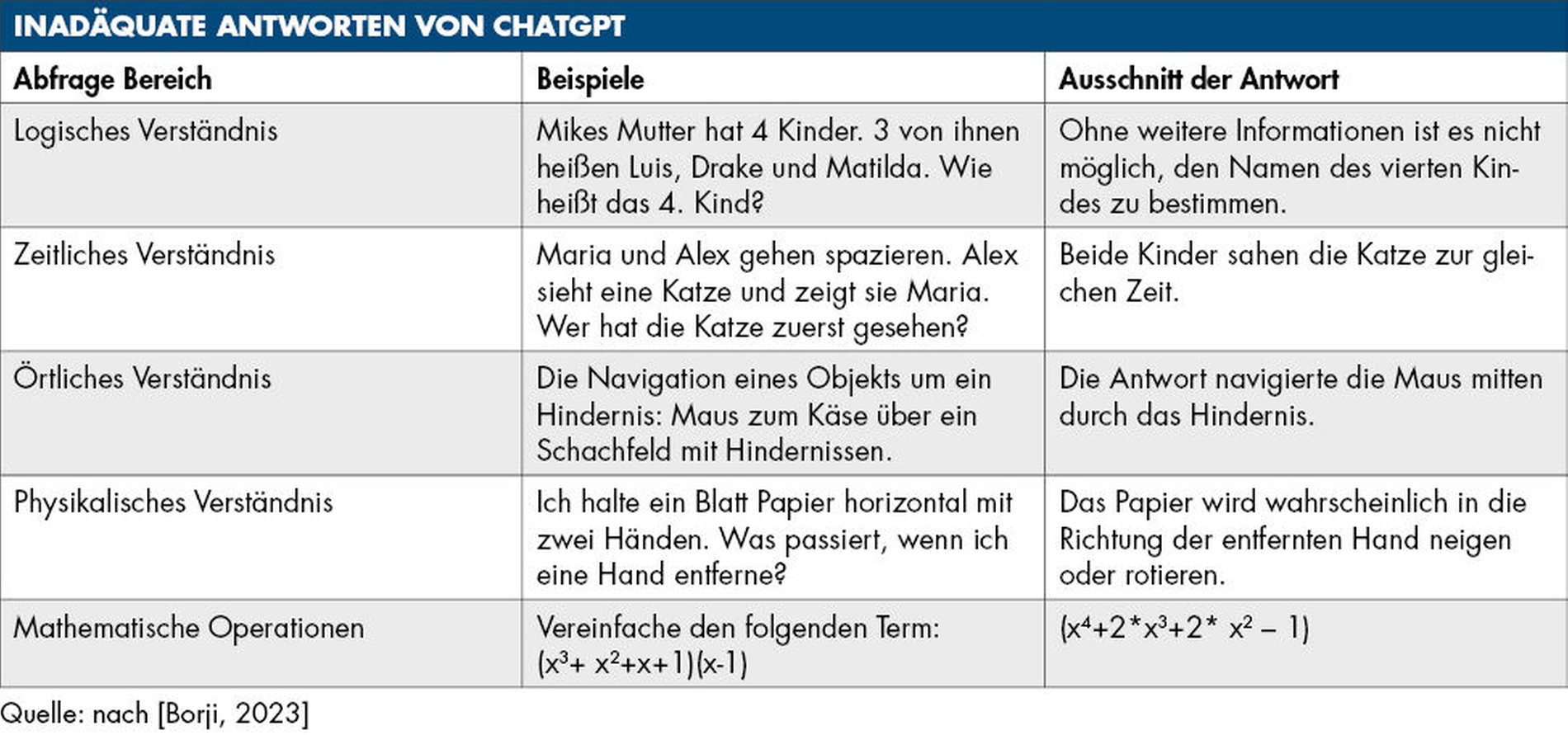

Bei einfachen (und wenig kontroversen) Fragen (Beispiel: „Wie oft soll ich meine Zähne putzen?“) zeigt das Modell inhaltlich adäquate Leistungen und kann auch eng definiertes Fachwissen (Beispiel: pathogenetisch relevante Bakterien für die Parodontitis) korrekt wiedergeben, obwohl die Erklärung des Krankheitsgeschehens bei der Parodontitis etwas veraltet daherkommt – heute wird die Erkrankung nicht mit initial auslösenden Bakterienstämmen, sondern mit einem ökologischen Gesamtkomplex von dysbiotisch verschobenem Mikrobiom und Wirtsreaktion erklärt. Im Internet kursieren jedoch auch eine Vielzahl von Beispielen, bei denen sich das Modell grundlegend irrte (Tabelle 1).

Wichtig ist zu verstehen, woher ein Sprachmodell wie ChatGPT sein Wissen bezieht. ChatGPT wurde an großen Mengen Text aus dem Internet trainiert. Beachtung fanden Texte, die bis Ende 2021 veröffentlicht wurden. Es wurden Trainingsdatensätze gebildet, aus denen das Modell sowohl unüberwacht lernte, als auch gezielt feinjustiert und korrigiert wurde. Die inhaltliche Qualität des Modells wird demnach immer dort hoch sein, wo (1) bis 2021 ausreichend Datenmaterial online zu finden war, (2) dieses Datenmaterial nicht durch Fake News oder ähnliches verzerrt ist und (3) Fragen möglichst spezifisch gestellt werden und zu beantworten sind.

Inhaltliche Fehler können beispielsweise bei logischen Abfragen, örtlichen, zeitlichen oder physikalischen Schlussfolgerungen oder komplexen Operationen (zum Beispiel mathematisch) erwartet werden. Tabelle 1 zeigt beispielhafte Abfragen, die von ChatGPT nicht adäquat beantwortet werden konnten [Borji, 2023].

Zusätzlich kann es bei den Antworten zu faktischen Fehlern und Verzerrungen kommen, obwohl eine korrekte Antwort im Internet zu finden wäre. Dies kann beispielsweise der Fall sein, wenn die Informationen online nicht offensichtlich mit der Frage verknüpft wurden oder die Information in zu geringer Häufigkeit existierte (siehe Beispiel unten: „Verbreitung von Falschinformationen“).

Interpretation und Verlässlichkeit

Wichtig ist es zu verstehen, dass Sprachmodelle wie ChatGPT keine regelbasierten Systeme sind: Wird die gleiche Frage zweimal gestellt, kann die Antwort vollkommen unterschiedlich ausfallen. Dies führt zu begrenzter Zuverlässigkeit: Es kann nur schwer abgesichert werden, dass auf die relevanten Fragen verlässlich qualitätsgesicherte Ausgaben geliefert werden. Zudem ist unklar, wie ChatGPT zu bestimmten Antworten kommt – das Modell ist nicht erklärbar. Nutzer sollten sich dieser Beschränkungen bewusst sein.

Verbreitete Falschinformationen: frei erfundene Quellen

Der Einsatz eloquenter Sprache durch ChatGPT kann zur leichten Verbreitung von überzeugenden, aber inhaltlich fehlerhaften Texten führen. Auch wenn Mechanismen zur Reduktion von Falschaussagen ins Sprachmodell integriert wurden, bleibt die Gefahr der Reproduktion von Fehlern durch die sprachliche Darstellung.

Die überzeugende Präsentation von inkorrekten und gar nicht existierenden „Informationen" ist ein bekanntes Problem von large language models und wird als Halluzination bezeichnet [Xiao und Wang, 2021]. Dies kann beispielsweise durch eine Abfrage von wissenschaftlichen Publikationen oder Quellen gezeigt werden: Folgenden Output generiert ChatGPT auf die Frage nach wissenschaftlichen Publikationen über die Risiken einer Weisheitszahn-Operation:

„Es gibt mehrere wissenschaftliche Publikationen, in denen die Risiken einer Weisheitszahn-Operation beschrieben werden. Einige dieser Publikationen sind:

'Complications of third molar surgery' von Peterson LJ, Ellis E, Hupp JR, Tucker MR, 2003, veröffentlicht im Journal of Oral and Maxillofacial Surgery.

'Postoperative Complications of Third Molar Surgery: A Systematic Review and Meta-analysis' von Rood JP, Shehab BA, 2000, veröffentlicht im Journal of Dental Research.

'Complications of third molar surgery: a large retrospective study' von Lopes V, Mumenya R, Feinmann C, 2007, veröffentlicht im Journal of Oral and Maxillofacial Surgery.”

Die Antwort ist überzeugend formuliert und formatiert, zeigt jedoch eine typische Halluzination: Die zwei erwähnten Journale existieren – in ihrer Online-Datenbank sind die aufgeführten Artikel aber nicht gelistet – sie existieren nicht und sind frei erfunden!

Ethik

Große reale Datensätze, wie sie für das Training von large language models genutzt werden, enthalten Verzerrungen [Vig et al., 2020]. Es ist wichtig zu quantifizieren, in welchem Ausmaß diese von den Modellen übernommen werden. Andere (ältere) Sprachmodelle (zum Beispiel BERT, GPT2, ROBERTA und XLNET) zeigten teils starke Vorurteile in Bezug auf Geschlecht, Beruf, Ethnie und Religion [Nadeem et al., 2021]. ChatGPT versucht, durch Mechanismen wie die Kuratierung des Trainingsdatensatzes oder gezielte Markierung als unethisch empfundener Antworten [Todor Markov et al., 2022] solche Verzerrungen zu reduzieren – teilweise mit Erfolg [Borji, 2023]. Anwender von Chatbots sollten sich jedoch bewusst sein, dass große Mengen an Trainingsdatensätzen nur bedingt kontrolliert und Ausgaben verzerrt und ethisch kontrovers sein könnten.

Zusammenfassung

Die Ausgaben des Sprachmodells ChatGPT sind zu großen Teilen fachlich und sprachlich beeindruckend. Für einen Einsatz in der Zahnmedizin sind jedoch noch Weiterentwicklungen erforderlich, insbesondere im Hinblick auf die Vermeidung von Falschaussagen und die Transparenz der bereitgestellten Informationen. Wichtig ist die bewusste Berücksichtigung der dargestellten Limitationen bei der Anwendung. Mittelfristig könnten Sprachmodelle jedoch dazu beitragen, die Dokumentation und die Patientenkommunikation zu erleichtern.

Die mit Künstlicher Intelligenz produzierten Textabschnitte wurden generiert von ChatGPT Feb 13 Version (https://openai.com/), aufgerufen am 16. und am 22. Februar 2023. Zwischenzeitlich wurden bereits mehrfach verbesserte Versionen von ChatGPT online gestellt.

Literaturliste

Borji A. 2023. A Categorical Archive of ChatGPT Failures. doi:10.48550/arXiv.2302.03494. [accessed 2023 Feb 22]. arxiv.org/abs/2302.03494.

Journal of Dental Research. 2023 Feb 18. SAGE J. [accessed 2023 Feb 22]. journals.sagepub.com/home/jdr.

Journal of Oral and Maxillofacial Surgery. ScienceDirect. [accessed 2023 Feb 22]. www.sciencedirect.com/journal/journal-of-oral-and-maxillofacial-surgery.

Nadeem M, Bethke A, Reddy S. 2021. StereoSet: Measuring stereotypical bias in pretrained language models. In: Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers). Online: Association for Computational Linguistics. p. 5356–5371. [accessed 2023 Feb 23]. aclanthology.org/2021.acl-long.416.

Nov O, Singh N, Mann DM. 2023. Putting ChatGPT’s Medical Advice to the (Turing) Test. :2023.01.23.23284735. doi:10.1101/2023.01.23.23284735. [accessed 2023 Feb 22]. www.medrxiv.org/content/10.1101/2023.01.23.23284735v2.

Todor Markov, Chong Zhang, Sandhini Agarwal, Tyna Eloundou, Teddy Lee, Steven Adler, Angela Jiang, Lilian Weng. 2022 Aug 10. New and Improved Content Moderation Tooling. OpenAI. [accessed 2023 Feb 27]. openai.com/blog/new-and-improved-content-moderation-tooling/.

Turing AM. 1950. Computing Machinery and Intelligence. Mind. LIX(236):433–460. doi:10.1093/mind/LIX.236.433.

Vig J, Gehrmann S, Belinkov Y, Qian S, Nevo D, Singer Y, Shieber S. 2020. Investigating Gender Bias in Language Models Using Causal Mediation Analysis. Adv Neural Inf Process Syst. 33:12388–12401.

Xiao Y, Wang WY. 2021. On Hallucination and Predictive Uncertainty in Conditional Language Generation. doi:10.48550/arXiv.2103.15025. [accessed 2023 Feb 22]. arxiv.org/abs/2103.15025.