Entscheidet KI fairer als der Mensch?

Als Ende 2020 die österreichische Arbeitsmarktagentur AMS einen Algorithmus einsetzte, um die Art der Job- und Weiterbildungsangebote an die individuellen Profile von Arbeitssuchenden anzupassen, war die Aufregung im Land groß. Viele kritisierten das Vorgehen, weil es auf historischen Daten basierte und damit potenziell Menschen benachteilige, die schon in der Vergangenheit am Jobmarkt diskriminiert wurden: Frauen erhielten beispielsweise per se einen Punktabzug, Mütter mussten einen weiteren Punktabzug hinnehmen. Dies könnte wiederum ihre Chancen verringern, an Wiedereingliederungsmaßnahmen teilzunehmen.

Aber nicht nur auf dem Arbeitsmarkt, auch im Banken- und Personalwesen oder in der Medizin ist der Einsatz von Algorithmen verbreitet – und wird kontrovers diskutiert. Wie es um die Akzeptanz von Algorithmus-basierten Entscheidungen steht, hat der Mannheimer Datenwissenschaftler Prof. Dr. Florian Keusch mit Prof. Dr. Frauke Kreuter von der Ludwig-Maximilians-Universität München untersucht.

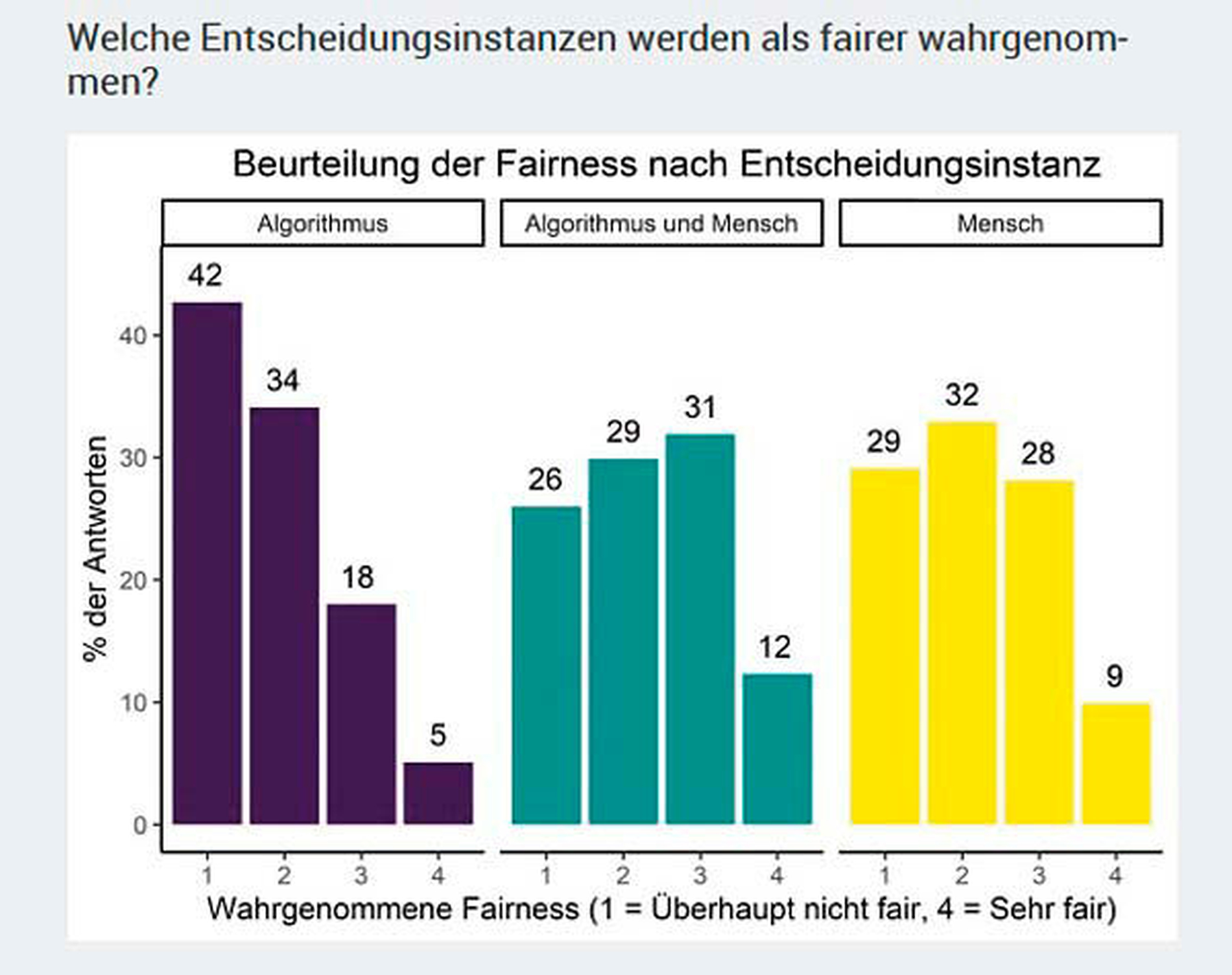

Am besten bewertet wird Das Mensch-KI-Team

Ihre Studie belegt, dass Entscheidungen, an denen Menschen beteiligt sind, als fairer beurteilt werden als solche, die ein Algorithmus allein trifft. „Die Ergebnisse lassen darauf schließen, dass die Nutzung von Algorithmen ohne zusätzliche Kontrolle durch den Menschen als besonders problematisch angesehen wird“, konstatiert Keusch. „Es ist also nicht der Einsatz von Algorithmen an sich, der umstritten ist."

Die Forschenden haben für ihre Studie mehr als 4.000 Personen online befragt. Diese mussten Fragen beantworten, wie fair und akzeptabel sie die Nutzung von KI-gestützten Entscheidungen in vier unterschiedlichen Szenarien beurteilen: bei der Vergabe eines Finanzprodukts, bei Job-Bewerbungen, bei Gefängnisstrafen und bei Maßnahmen für Arbeitssuchende. Fazit: Die Fairness der Entscheidungsinstanz „Algorithmus und Mensch” wird geringfügig höher bewertet als wenn Menschen allein entscheiden.

In allen vier in der Umfrage erwähnten Bereichen – Medizin gehörte nicht dazu – ist der Einsatz von KI schon heute zumindest in Teilen Realität. Das sogenannte automated decision making (ADM) wird von Unternehmen und staatlichen Einrichtungen vor allem mit dem Argument genutzt, die Effizienz von Entscheidungsprozessen erhöhen und den Einfluss persönlicher Einstellungen der Entscheider reduzieren zu wollen.

Ist der Bias erstmal programmiert, bleibt er im System

Nichtregierungsorganisationen aber auch Forschende haben indes immer wieder nachgewiesen, dass ein einmal in die Programmierung einer KI eingeflossener Bias zur tendenziellen Benachteiligung von bestimmten Bevölkerungsgruppen führen kann.

Wo es um Akzeptanz geht, ist meist auch Transparenz ein großes Thema. Viele Algorithmen ähnelten einer Blackbox, schreiben die Forschenden – selbst für diejenigen, die sie verwenden. Der Grund: Sie werden teilweise extern eingekauft, so dass Entscheidende selbst gar nicht wissen, wie der Algorithmus zu seinem Ergebnis kommt. „Aus wissenschaftlicher und gesellschaftlicher Sicht ist es natürlich wünschenswert zu wissen, wie der Algorithmus einzelne Kriterien gewichtet“, sagt Keusch. Auch das sei eine wichtige Voraussetzung für dessen gesellschaftliche Akzeptanz.

Viele Algorithmen ähneln einer Blackbox

Seit März 2021 gibt es in Deutschland mit der Internetplattform „Unding” eine Anlaufstelle für Menschen, die sich durch die Entscheidungen von KI-unterstützten Systemen benachteiligt fühlen und von den verantwortlichen Unternehmen Aufklärung fordern wollen. Das Projekt von Bertelsmann Stiftung, Schöpflin Stiftung und der Nichtregierungsorgsanisation Algorithmwatch versteht sich dabei als Vermittler.

„Wer bisher gegen Probleme durch automatisierte Entscheidungen angehen wollte, landete meist in einer Sackgasse”, schreiben die Macher. „Zuständige Firmen reagierten auf Beschwerden nicht, oder für Widerspruch gab es erst gar keine Möglichkeit.” Seit 2022 ist Unding auch direkt auf verbraucherzentrale.de erreichbar.

Zur Studie

Mehr zum Thema: Künstliche Intelligenz

Künstliche Intelligenz (KI) wird künftig auch eine bedeutende Rolle in der Zahnmedizin spielen. Noch ist die Technik jedoch mit vielen Unwägbarkeiten behaftet.

169

169