Patientenaufklärung: Wie verständlich sind KI-Texte?

Der britische National Health Service (NHS) hat in seiner langfristigen Planung die Integration von KI in die Versorgung fest verankert, verbunden mit dem Anspruch, Informationen niedrigschwellig und für alle Bevölkerungsgruppen verständlich bereitzustellen. Auch hierzulande wird KI zunehmend als Werkzeug zur Patientenkommunikation diskutiert. Gleichzeitig ist bekannt, dass ein erheblicher Anteil der Erwachsenen Schwierigkeiten hat, komplexe medizinische Texte zu verstehen. Diese Diskrepanz wirft die Frage auf, inwieweit KI-gestützte Texte tatsächlich eine Hilfe darstellen.

Materialien und Methoden

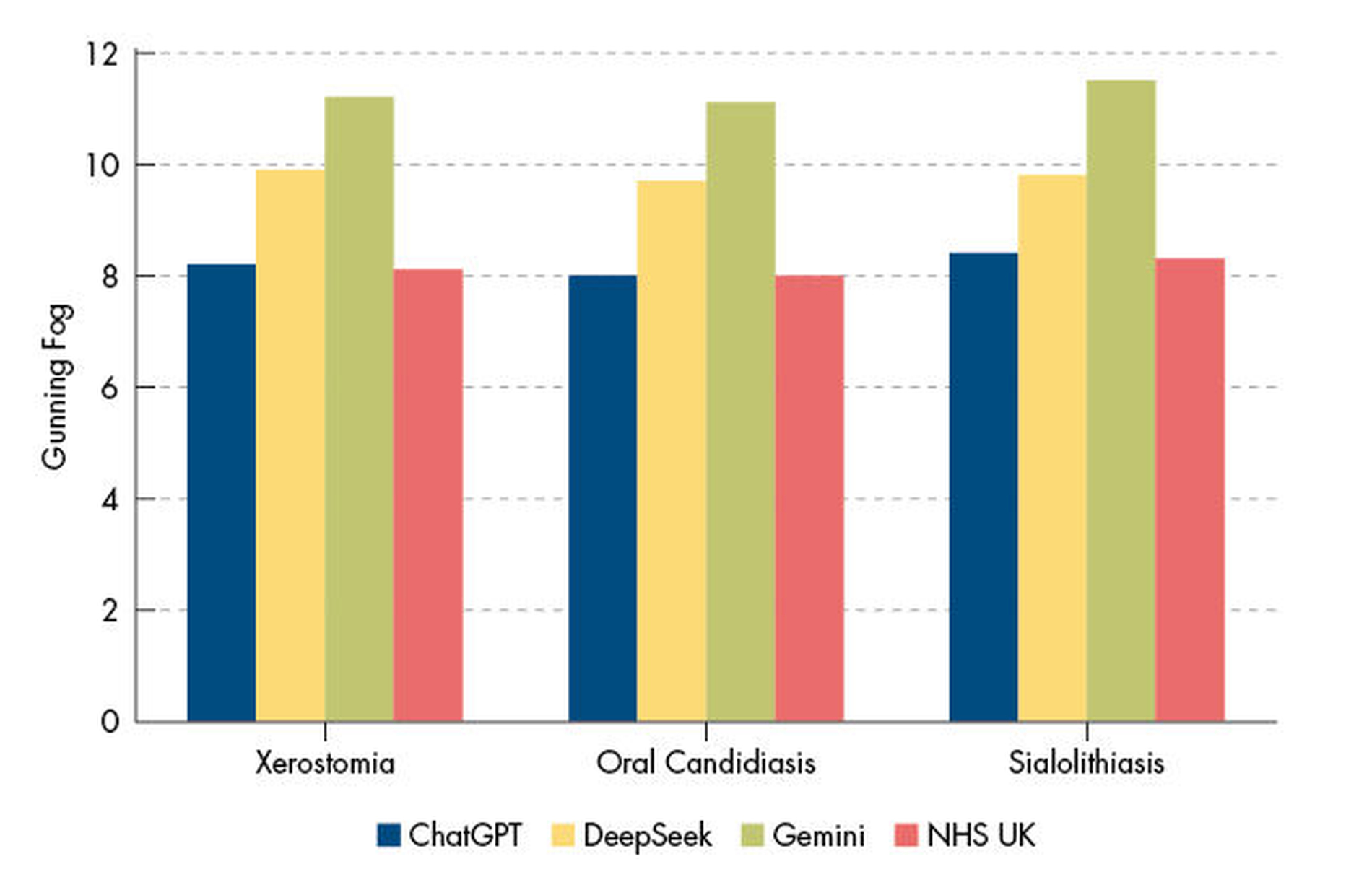

In einer aktuellen explorativen Studie wurden die drei Large Language Models ChatGPT (GPT-4), DeepSeek (V3) und Gemini (Flash 2.5) genutzt, um Patienteninformationen zu Xerostomie, oraler Candidose und Sialolithiasis zu erstellen. Die so generierten Texte wurden mit den offiziellen NHS-Informationsblättern zu denselben Erkrankungen verglichen. Zur Analyse dienten etablierte Lesbarkeitsindizes: der Flesch Reading Ease Score (FRES), die Flesch-Kincaid Grade Level (FKGL) sowie der Gunning Fog Index. Diese Metriken schätzen, auf welchem Bildungsniveau ein Text verständlich ist.

Ergebnisse

Die NHS-Materialien schnitten in allen Kategorien am besten ab und erreichten durchgängig eine Lesestufe, die für Schülerinnen und Schüler im Alter von 11 bis 14 Jahren geeignet ist. Unter den KI-Modellen zeigte ChatGPT die größte Nähe zu diesem Niveau, blieb aber etwas anspruchsvoller. DeepSeek generierte deutlich komplexere Texte, während Gemini die am schwersten verständlichen Informationen lieferte, teils auf einem Niveau, das eine Hochschulbildung voraussetzt. Diese Ergebnisse bestätigten sich über alle drei untersuchten Krankheitsbilder hinweg.

Fazit

Die Untersuchung zeigt eindeutig: LLMs können zwar bereits nützliche Informationen bereitstellen, ihre Texte erreichen in der derzeitigen Form jedoch noch nicht die Verständlichkeit professionell erstellter Materialien. Gerade in einem Bereich wie der Zahnmedizin, in dem Patientinnen und Patienten häufig einfache und praxisnahe Aufklärung benötigen, besteht die Gefahr, dass komplexe KI-Texte das Verständnis eher erschweren. Für die Nutzung in der Praxis bedeutet das: KI kann ein hilfreiches Werkzeug sein, ersetzt aber nicht die sorgfältige redaktionelle Nachbearbeitung durch Fachpersonal. Erst durch sprachliche Anpassung und inhaltliche Prüfung lassen sich patientengerechte Informationsmaterialien sicherstellen.

Tukur Jido J, Al-Wizni A, Alkateb M, Salem N (2025): Comparative Assessment of Large Language Model Outputs and NHS Patient Information in Oral Medicine. Cureus 17(8): e90242. DOI: 10.7759/cureus.90242.