Wie KI die Evidenz in der Wissenschaft untergräbt

Die evidenzbasierte Zahnmedizin stützt sich unter anderem auf die Erhebung wissenschaftlicher Daten und deren strukturierte Bewertung. Leitlinien übersetzen diese Evidenz in verlässliche Handlungsempfehlungen und bilden damit ein zentrales Fundament klinischer Entscheidungen. Dieses System wird durch generative KI zunehmend gefährdet: Daten werden (teils) durch KI verzerrt oder komplett generiert, über verschiedene (teils dubiose) Wege trotz allem publiziert und schlussendlich in den wissenschaftlichen Translationsprozess aufgenommen. Eine klare Trennung zwischen korrekten und falschen Inhalten wird zunehmend erschwert; am Ende droht das Risiko der Strangulation des Wissenschaftssystems durch das Motto „Effizienzsteigerung für mehr Forschung, die aber weniger vertrauenswürdig ist“.

Mit der zunehmenden Verbreitung generativer KI verändert sich das wissenschaftliche Umfeld grundlegend. Große Sprachmodelle können Texte analysieren, Inhalte verdichten, Literatur auswerten oder Patienteninformationen formulieren. Doch sie tun dies nicht auf der Grundlage eines wissenschaftlichen Verständnisses, sondern rein probabilistisch. Sie erzeugen sprachlich überzeugende Antworten, ohne die Gültigkeit, die Herkunft oder die Qualität der zugrunde liegenden Informationen zu verstehen. Damit wachsen neben den Möglichkeiten vor allem die Risiken, und diese betreffen zunehmend die Integrität wissenschaftlicher Evidenz.

Neben den Möglichkeiten wachsen vor allem die Risiken

Eine der am häufigsten beschriebenen Schwachstellen generativer KI ist das Erzeugen frei erfundener Inhalte. KI-Modelle neigen beispielsweise dazu, Literaturangaben teils zu halluzinieren: Sie konstruieren DOI-Nummern, die formal korrekt erscheinen, nennen existierende Autorinnen und Autoren in fiktiven Kontexten oder führen wissenschaftliche Fachjournale an, die nie existiert haben. Solche Quellen wirken plausibel, sind aber inhaltlich wertlos. Werden sie in Literaturrecherchen oder wissenschaftlichen Arbeiten verwendet, verzerren sie die Basis jeder evidenzgestützten Analyse.

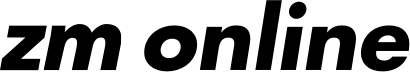

Besonders problematisch sind Halluzinationen, wenn KI nicht nur als Textgenerator, sondern zunehmend als Recherche-Werkzeug eingesetzt wird. Eine Untersuchung des Tow Center for Digital Journalism [Jaźwińska und Chandrasekar et al., 2025] hat acht große KI-basierte Suchsysteme, darunter ChatGPT Search, Perplexity, Gemini, Copilot und Grok, auf deren Fähigkeit geprüft, journalistische Originalquellen korrekt wiederzugeben. Das Ergebnis war erschreckend: Über 60 Prozent der Antworten enthielten falsche oder unvollständige Angaben. Manche Systeme erfanden URLs, andere verschmolzen die Inhalte verschiedener Artikel miteinander. Auffällig war zudem, dass die Modelle ihre Aussagen mit großer Sicherheit präsentierten, selbst wenn sie vollständig falsch lagen.

Wer glaubt, durch die bezahlten „Premium Bots“ mehr Sicherheit zu haben, irrt: Premium-Versionen der Tools lieferten teils noch höhere Fehlerraten, bei gleichzeitig noch höherer Selbstsicherheit. Für die zahnmedizinische Forschung bedeutet dies: Wer die Literaturrecherche an ungeeignete KI-Tools auslagert, riskiert, dass fehlerhafte oder erfundene Quellen den Weg in wissenschaftliche Argumentationen finden. Zwar können diese Tools zahlreiche Aufgaben effizient bewältigen – das menschliche Arbeitspensum aber verlagert sich dann: Zeitintensiv ist nicht mehr die Extraktion von Daten, sondern die Kontrolle des Recherche- und Extraktionsprozesses.

Ein Problem ist der organisierte Wissenschaftsbetrug

Parallel zu diesen technischen Risiken entwickelt sich ein weiteres, strukturell noch gefährlicheres Problem: der organisierte Wissenschaftsbetrug. KI-Systeme können innerhalb kürzester Zeit komplette Forschungsarbeiten inklusive Datensätzen, Tabellen und statistischen Auswertungen erzeugen. Ein Beispiel aus der ophthalmologischen Forschung zeigte, wie GPT-4 in wenigen Minuten einen klinischen Datensatz konstruierte, der einem durch echte Studien erzeugten Datensatz täuschend ähnlich sah und gleichzeitig eine Therapie als überlegen darstellte, obwohl die realen Daten das Gegenteil belegten [Taloni et al., 2023].

Betrugsnetzwerke können solche Fähigkeiten nutzen, um in kurzer Zeit gefälschte, aber überzeugend anmutende wissenschaftliche Studien zu platzieren. Dadurch wird eine neue Ebene wissenschaftlicher Täuschung möglich, die herkömmliche Prüfprozesse kaum noch erkennen können.

zm-Serie „KI für die Zahnmedizin“

Mitglieder des Arbeitskreises „Artificial Intelligence in Dental Medicine“ (AIDM) beleuchten die Chancen und Limitationen von KI in der zahnärztlichen Praxis.

Teil 1: „Automatisierungs-Bias – Wie KI unseren klinischen Blick verzerren kann“ (zm 17/2025)

Teil 2: „Mundschleimhautveränderungen – Mundschleimhautdiagnostik mit künstlicher Intelligenz“ (zm 20/2025)

Teil 3: „Sprachdokumentationswerkzeuge – KI-basierte Sprachdokumentation“ (zm 22/2025)

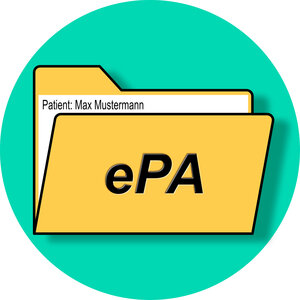

Aktuelle Untersuchungen zeigen, dass weltweit seit etwa 2010 Netzwerke aus „Paper Mills“ entstehen, die gefälschte Studien industriell produzieren. Das geschieht professionell, massenhaft und ist zuletzt durch die Verwendung von KI häufig kaum von echten Forschungspublikationen zu unterscheiden. Diese Arbeiten gelangen über gekaufte Peer Reviews, manipulierte Editorialsysteme und dubiose Journale („predatory journals“) in wissenschaftliche Datenbanken. Die Zahl derartiger Veröffentlichungen wächst rasant und übersteigt in manchen Bereichen bereits das Wachstum authentischer Forschung. So stammten 2022 bereits mehr als drei Prozent der Artikel im Bereich Medizin und Biologie aus Paper Mills – diese Disziplinen bilden damit den traurigen Spitzenreiter in der Wissenschaft (gefolgt von Chemie und Materialwissenschaften mit 2,5 Prozent) [Van Noorden, 2023].

Welchen Einfluss Fake-Studien haben, zeigt sich an folgendem (bekanntem) Beispiel: Der ehemalige britische Arzt Andrew Wakefield hatte 1998 einen Artikel in der Fachzeitschrift „The Lancet“ publiziert, in dem er fälschlicherweise behauptete, die Masern-Mumps-Röteln-Impfung (MMR) hänge mit Autismus zusammen [Eggertson, 2010]. Obwohl die Studie zurückgezogen wurde, weil der Autor die Daten gefälscht hatte, ist sie Basis weiterer Untersuchungen geworden – die falsche Schlussfolgerung hat sich mittlerweile bis in die US-Regierung verbreitet. Viele andere Fälschungen werden leider nicht aufgedeckt.

Falsche Daten von heute sind Trainingsdaten von morgen

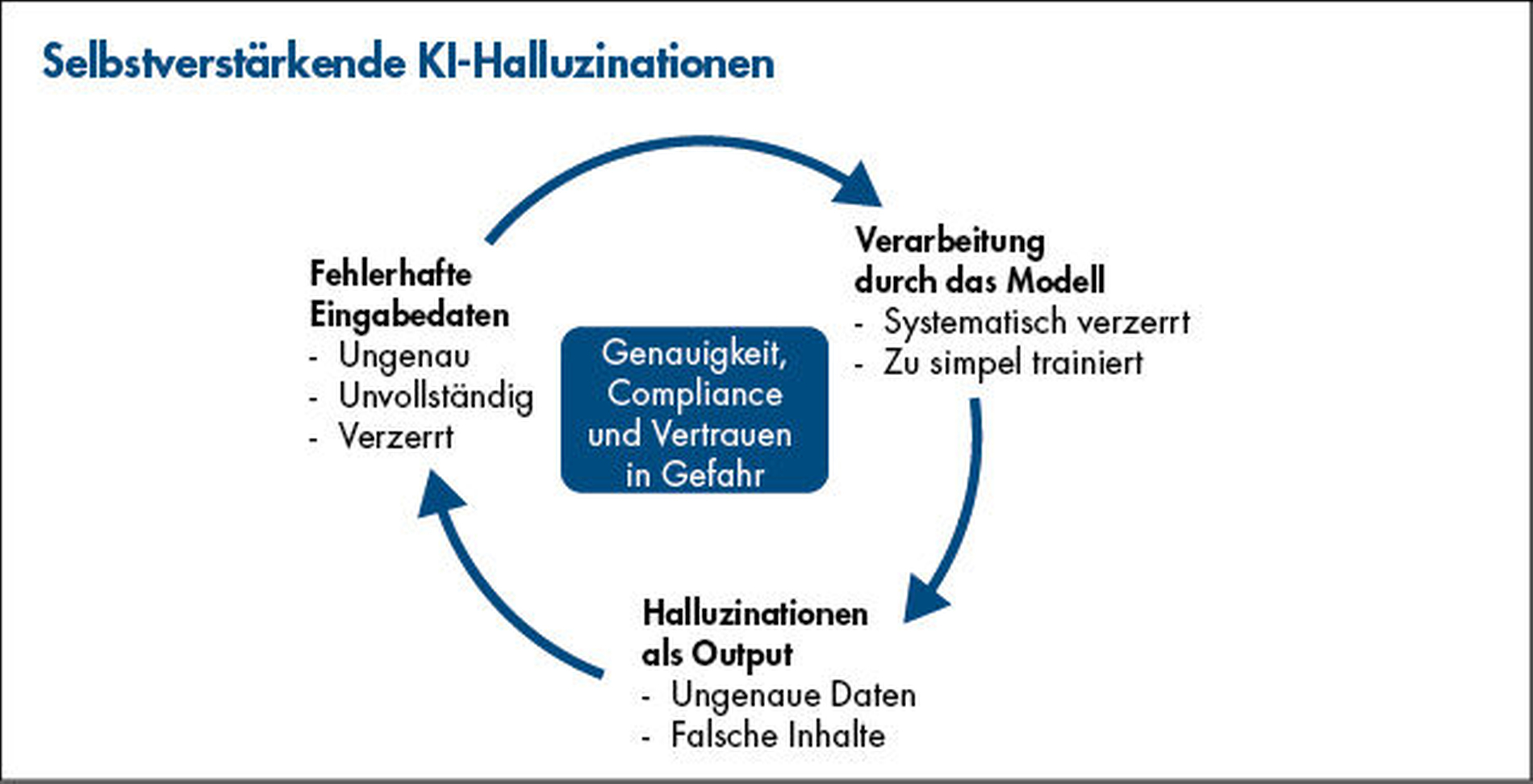

Noch gravierender wird diese Entwicklung durch einen systemischen Kreislauf: Sobald gefälschte oder fehlerhafte Inhalte in wissenschaftliche Datenbanken oder Preprint-Server gelangen, werden sie zu einem Teil der digitalen Wissenslandschaft. KI-Suchsysteme greifen diese Inhalte auf, verarbeiten sie und verbreiten sie weiter. Modelle der nächsten Generation verwenden sie später als Trainingsdaten, ohne zu unterscheiden, ob die Informationen korrekt sind oder nicht.

Dadurch entsteht ein selbstverstärkender Mechanismus, in dem falsche Evidenz nicht nur reproduziert, sondern zunehmend verfestigt wird. So können falsche Therapiekonzepte in die breite Öffentlichkeit gelangen und funktionierende Methoden ersetzen. Es besteht somit die durch KI aktiv beförderte Gefahr des „Deskilling“, ein medizinischer Wissensverlust für die nächsten Generationen.

Auch die Zahnmedizin sieht sich mit einer Gefahr konfrontiert, die weit über vereinzelte Fehler hinausgeht. Gerade in Fachgebieten, in denen Studien häufig mit kleinen Fallzahlen arbeiten oder Evidenzlücken bestehen, können wenige gut platzierte Fälschungen ausreichen, um Trends zu verfälschen, therapeutische Entscheidungen zu beeinflussen oder Leitlinienprozesse systematisch zu stören.

Nötig ist mehr methodische Wachsamkeit

Die Integration generativer KI in wissenschaftliche Arbeitsabläufe eröffnet neue Möglichkeiten, verlangt aber eben auch eine neue Form methodischer Wachsamkeit. KI kann unterstützen, aber sie kann ebenso Evidenz verzerren, verfälschen und untergraben. Entscheidend wird sein, dass die Zahnmedizin die Risiken erkennt und verantwortungsvoll reguliert. Wissenschaftlich geschulte Fachleute, transparente Datenquellen, robuste Qualitätskontrollen und klar definierte Grenzen für den Einsatz generativer Systeme sind notwendig, um die Integrität der wissenschaftlichen Basis zu schützen.

Denn eines ist sicher: Eine KI, die mit falschen Informationen gefüttert wird, erzeugt nicht nur weitere Fehler, sie vervielfältigt und streut diese global. Nur durch konsequentes kritisches Prüfen und eine enge Verbindung zwischen menschlicher Expertise und technischer Innovation wird es gelingen, die Evidenz in der Zahnmedizin vor einer schleichenden Erosion zu bewahren.

Literaturliste

Eggertson L. Lancet retracts 12-year-old article linking autism to MMR vaccines. CMAJ. 2010 Mar 9;182(4):E199-200. doi: 10.1503/cmaj.109-3179. Epub 2010 Feb 8. PMID: 20142376; PMCID: PMC2831678.

Jaźwińska and Chandrasekar et al.: AI Search Has a Citation Problem. Columbia Journalism Review, März 2025. www.cjr.org/tow_center/we-compared-eight-ai-search-engines-theyre-all-bad-at-citing-news.php.

R.A.K. Richardson, S.S. Hong, J.A. Byrne, T. Stoeger, & L.A.N. Amaral, The entities enabling scientific fraud at scale are large, resilient, and growing rapidly, Proc. Natl. Acad. Sci. U.S.A. 122 (32) e2420092122, doi.org/10.1073/pnas.2420092122 (2025).

Taloni A, Scorcia V, Giannaccare G (2023) Large language model advanced data analysis abuse to create a fake data set in medical research. JAMA Ophthalmol 141(12):1174–1175. doi: 10.1001/jamao-phthalmol.2023.5162.

Richard Van Noorden: How big is science’s fake-paper problem? Nature 623, 466-467 (2023) doi: doi.org/10.1038/d41586-023-03464-x.